导读 AI初创公司Groq在英伟达财报发布前夕,在社交媒体中发布了一篇文章,表示该公司所研发的LPU推理性能是英伟达GPU的10倍,而LPU的研发成本仅...

AI初创公司Groq在英伟达财报发布前夕,在社交媒体中发布了一篇文章,表示该公司所研发的LPU推理性能是英伟达GPU的10倍,而LPU的研发成本仅仅是英伟达GPU的1/10。很多人都表示LPU成为了GPU的又一个挑战者,究竟能否挑战成功还未可知。

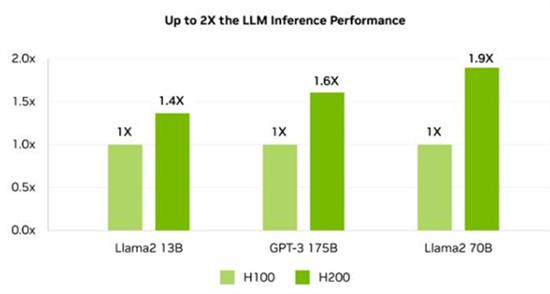

英伟达在人工智能席卷之下成为了头部企业,近年来有很多的挑战者,不断向英伟达发起冲击,那么此次Groq公司所研发的LPU性能究竟如何,记者对LPU进行了测试。

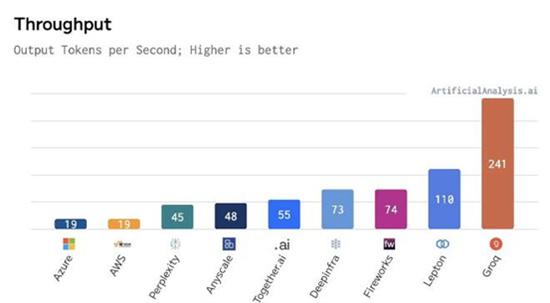

LPU并不是大模型,而是类似于一个大模型的加速接口,在经过Groq加速推理的开源大模型运转,使用之后给人最直观的感受就一个字“快”,根据记者的测试结果可以看到Groq的推理性能,基本上都在每秒270个Token左右,有些网友表示测试的时候每秒最高可以达到500Token左右。

Groq公司表示公司所研发的LPU,主要是克服LLM所出现的两个瓶颈,内存宽带以及计算密度,如果针对LLM而言LPU的计算能力非常快,减少了每一个单词的计算时间,就能以更快速度的生成文本序列,另外LPU如果和GPU相比,除了能够消除外部瓶颈,使用LPU能够在LLM中,不管是在计算密度或者是在内存宽带上,都能够给用户提供更好的性能。

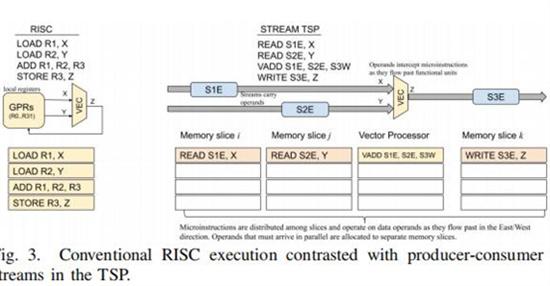

在模型架构方面Groq使用了张量流处理,用来加速人工智能,或者是机器学习以及高性能计算中,一些复杂工作中的超强负载,根据该公司所公开的技术资料表示,张流量处理它就是一种功能切片的微架构,当一些计算数据经过这种切片时,每一个功能单元都可以根据自己的需求,选择性的截取数据获得自己想要的计算结果,再将计算结果传递回数据流。

虽然Groq对LPU的功能夸夸其谈,但是适用范围究竟能不能跟上AI应用的发展速度,还充满了不确定性。